ИИ на службе преступников: чего ждать в ближайшем будущем

Михаил Кондрашин, 14/01/21

Злоумышленники, как и вполне законопослушные граждане и компании, заинтересованы в более эффективной автоматизации и совершенствовании процессов. У авторов исследования Trend Micro Malicious Uses and Abuses of Artificial Intelligence1 особую тревогу вызывают перспективы преступного применения ИИ, которые уже в ближайшие годы позволят злоумышленникам еще больше повысить изощренность своих атак и сделать их совершенно невыявляемыми. Поговорим о будущем киберпреступного применения технологии искусственного интеллекта.

Автор: Михаил Кондрашин, технический директор компании Trend Micro в России и СНГ

Вредоносные программы нового поколения

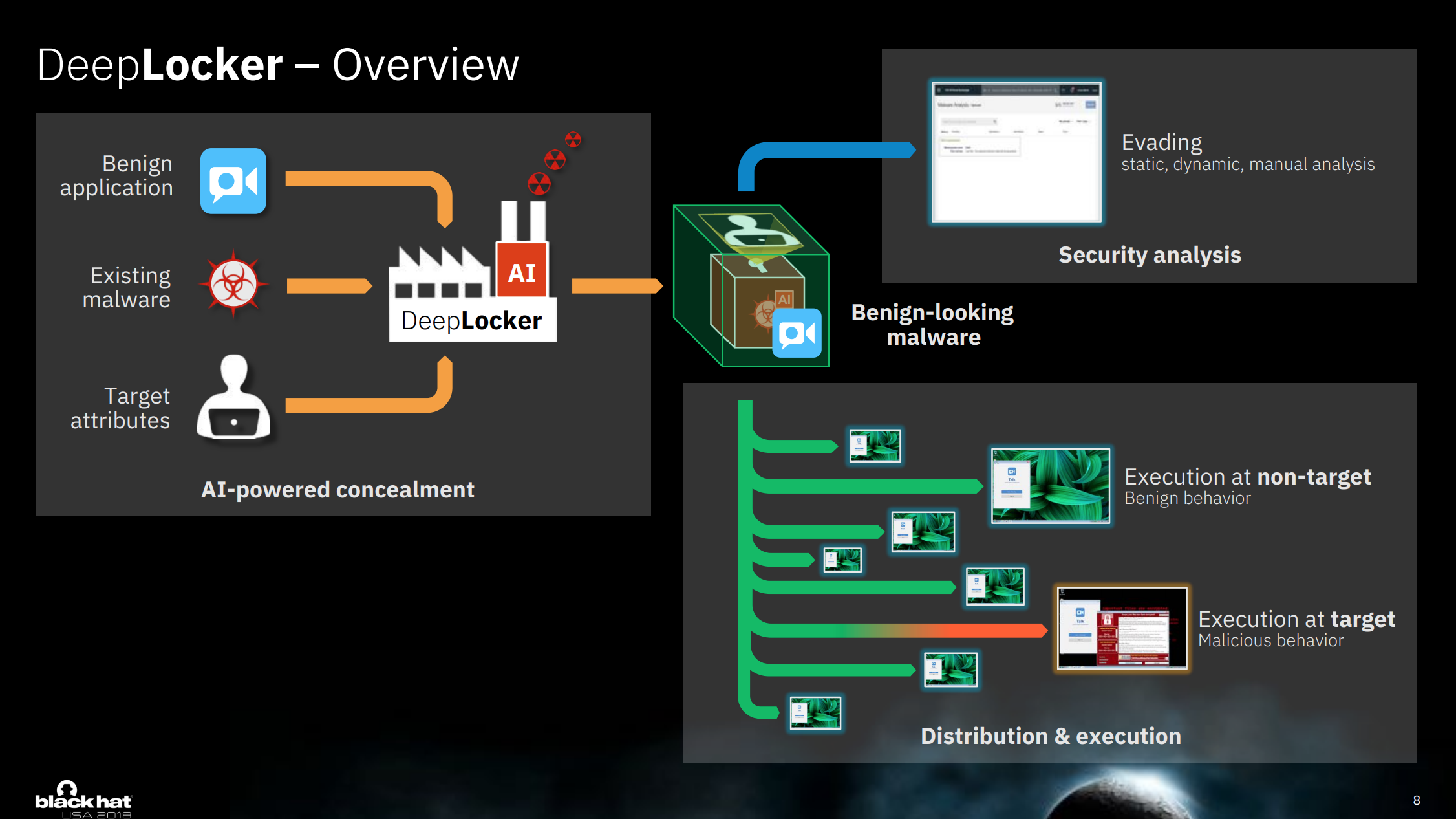

Исследователи из IBM недавно описали новый подход к вредоносному использованию ИИ. Их система DeepLocker2 встраивает возможности ИИ в саму вредоносную программу, чтобы улучшить методы уклонения от обнаружения. Это достигается благодаря эксплуатации общей особенности всех ИИ-систем – их необъяснимости.

Одной из важнейших функций любого вредоносного ПО является проверка окружения и идентификация цели. Они необходимы, чтобы вредоносные функции выполнялись именно там, где требуется злоумышленникам. Набор этих проверок примерно одинаков для всех вредоносных программ, поэтому служит достаточно надежным признаком, по которому антивирусы и системы защиты выявляют угрозы.

Авторы DeepLocker научились маскировать вредоносное поведение программы, реализовав проверки через глубокую нейронную сеть (Deep Neural Network, DNN), обученную на модели, соответствующей заданной цели. В результате для защитных систем проверки цели они выглядят как простые математические операции между матрицами.

Отсутствие необходимости явного кодирования условий запуска внутри вредоносного ПО значительно усложняет его анализ. Например, DeepLocker использует множество атрибутов для идентификации целевой машины: программное окружение, геолокацию и даже аудио и видео, что еще больше усложняет прогнозирование и определение условий запуска вредоносной программы.

Но авторы DeepLocker добавили еще один уровень обфускации: встроенная в нее нейросеть не выводит явного значения активации и не дает никакого ответа на вопрос "Я нахожусь на целевой машине?". Вместо этого программа вычисляет ключ для дешифровки полезной нагрузки. Но правильным этот ключ будет, лишь когда нейросеть положительно идентифицировала цель.

Таким образом, любая явная информация о цели вредоносной программы замаскирована в виде матричных факторов, что делает практически невозможным реверс-инжиниринг и идентификацию цели. До самого момента, когда вредоносная программа попадает в цель, остальной ее код полностью зашифрован и не поддается анализу.

Сложность реализации программ с подобной DeepLocker функциональностью пока является стоп-фактором для большинства разработчиков вредоносного софта. Однако по мере развития технологий и фреймворков можно ожидать массового появления вредоносов нового поколения.

Имитация живых людей

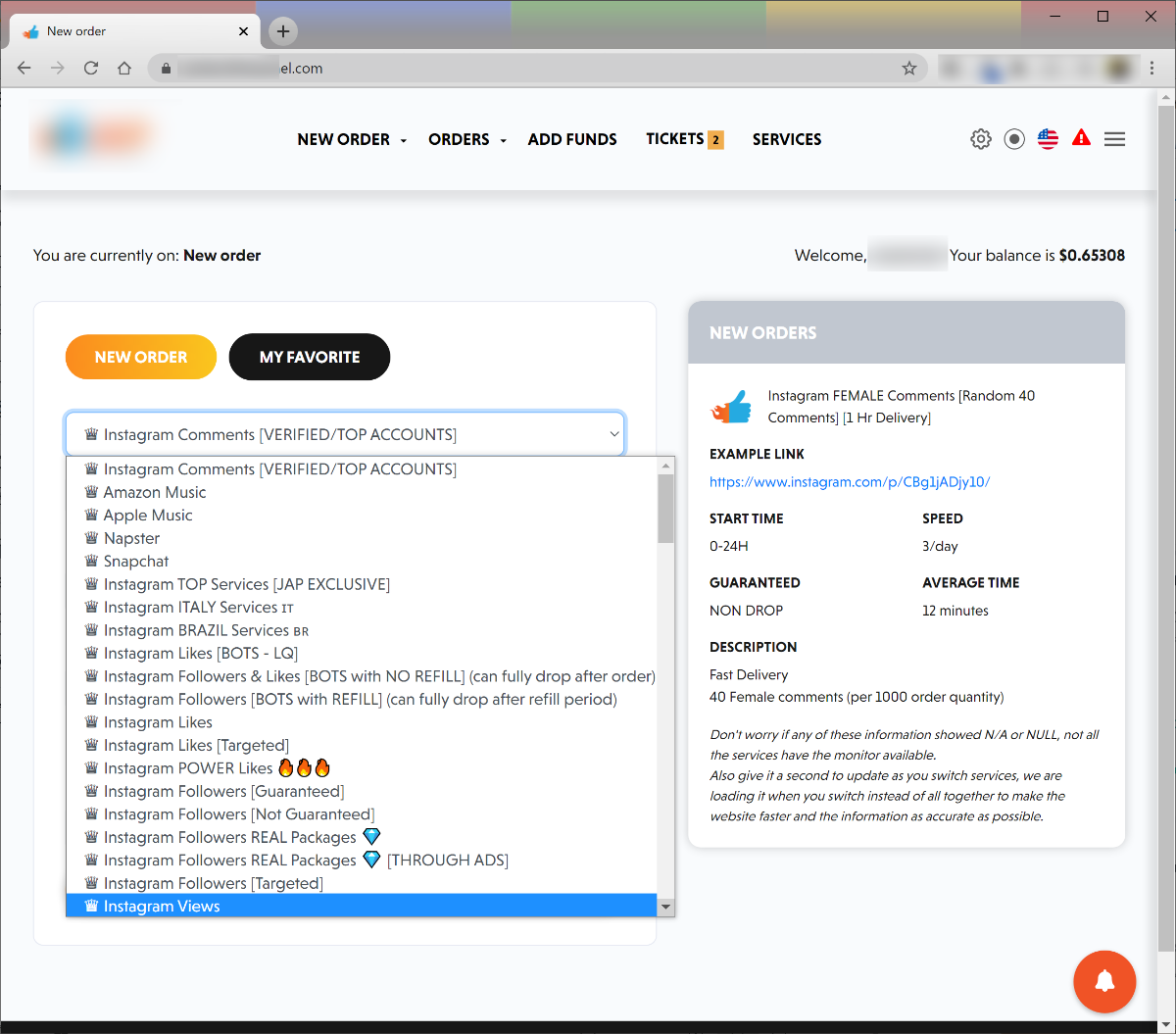

Один из наиболее популярных способов теневой монетизации – использование ботов, изображающих реальных пользователей социальных сетей и различных платформ с элементами социализации. Создатели таких ботов пытаются обмануть антибот-системы, чтобы накручивать популярность песне в Spotify или приложению в Play Market, добавить подписчиков аккаунту в Instagram, Twitter или Facebook, сгенерировать фальшивые лайки, просмотры и отзывы.

Поскольку эффективность обычных ботов невелика и подписчиков-ботов довольно быстро выявляют алгоритмы платформ, весьма распространенной практикой было привлечение к выполнению таких заданий живых людей. Но живые люди не хотят выполнять задания просто так, поэтому разработка ИИ, реалистично имитирующего поведение живых людей, будет просто глотком свежего воздуха для ботоводов-накрутчиков, спамеров и фишеров.

Использование ИИ позволит не только имитировать поведение живого человека в текущий момент, чтобы подписаться на аккаунт или поставить лайк. Обученные нейроботы будут поддерживать активности на фальшивых аккаунтах в соцсетях, создавая реалистичные профили с многолетней историей.

Социальная инженерия нового поколения

Эффективность "веерных" мошеннических рассылок относительно невелика. И хотя небольшие затраты на проведение таких кампаний позволяют очень быстро выйти в плюс, преступники будут рады любой технологии, которая повысит прибыльность.

ИИ может автоматически проанализировать базу адресов потенциальных жертв, отбраковать заведомо нерабочие адреса, а для остальных провести экспресс-OSINT, изучив доступную в открытых источниках информацию. Это позволит составить психопрофили и выбрать тех, кто легче поддастся обману.

Если кампания предполагает переписку с жертвой, анализ ответов на базе машинного обучения позволит предвосхитить наиболее распространенные реплики цели и выбирать наиболее результативную стратегию для дальнейшего общения.

Обман банковских систем онлайн-идентификации KYC (Know Your Customer, "знай своего клиента") – методика проверки личности клиента, которая проводится банками и другими финансовыми институтами. Обычно процедура KYC состоит из трех этапов:

- Идентификация – клиент предоставляет различные документы, сотрудник банка сравнивает внешний вид клиента с фотографией, а также может сфотографировать его, записать образцы голоса или снять отпечатки пальцев.

- Верификация – проверка предоставленных клиентом данных.

- Аутентификация – вход клиента в банковскую систему с использованием логина и пароля, ответа на контрольный вопрос или биометрических данных.

Из-за пандемии многие проводят идентификацию клиентов в дистанционном режиме с использованием видеосвязи.

Применение ИИ уже в ближайшем будущем позволит манипулировать видеопотоками в режиме реального времени, чтобы обмануть систему верификации. Используя возможность синтеза голоса и лица, преступники смогут злоупотреблять этими системами в широких масштабах, например, для создания новых банковских счетов или авторизации платежей. Это вызывает большие опасения, поскольку в настоящее время видео является одним из рекомендованных механизмов идентификации для банковской отрасли в нескольких странах.

Поиск значимых данных в массивах похищенной информации

Информация стала новым золотом, поэтому практически все операторы шифровальщиков-вымогателей не только шифруют данные своих жертв, но и похищают эти данные. В результате они получают дополнительный аргумент для выплаты им выкупа не только за расшифровку, но и за удаление украденных сведений.

Проблемой таких инцидентов для злоумышленников обычно становится объем данных. Найти в терабайтах информации что-то по-настоящему ценное – нетривиальная задача. И это как раз та область, в которой силен ИИ: обученная нейросеть может выявить и извлечь структурированную информацию из неструктурированных документов. Для этого можно воспользоваться, например, одной из реализаций технологии NER (Named Entity Recognition, "распознавание именованных сущностей").

NER – это направление технологии обработки языка для поиска в речи и тексте определенных категорий слов и словосочетаний. Сначала это были географические наименования, имена людей, организаций, адреса, однако в настоящее время это понятие значительно расширилось и с помощью NER стало возможно найти в тексте относительные и абсолютные даты, числа, номера. Разумеется, можно использовать NER для поиска данных банковских карт, телефонных номеров и банковских счетов.

Скорее всего, в ближайшем будущем в информационном поле появятся упоминания об ИИ, который использует NER для поиска ценных данных в похищенных документах.

Отравление данных глубокого обучения

Поскольку работа алгоритма нейросети базируется на данных машинного/глубокого обучения, можно ожидать появления принципиально нового вектора атак – отравления данных глубокого обучения.

Эти данные представляют собой огромные массивы чисел, причем в процессе работы алгоритма они могут дополняться и изменяться. Работа нейросети зависит от этих данных, но даже ее разработчик не сможет объяснить, почему нейросеть выдала тот или иной результат.

Преступники могут рассматривать эту конкретную проблему как источник возможностей. Изменение легитимной программы или библиотеки может быть замечено как по коду, так и по поведенческим аномалиям при его выполнении. А вот аномалии в модели глубокого обучения будет сложнее выявить из-за отсутствия объяснимости модели.

Таким образом, будущие вредоносные программы могут воздействовать на машины-хостеры, нацеливаясь, фильтруя или изменяя напрямую данные модели, а не библиотеки или API. В конце концов, изменение модели, вызванное вредоносным ПО, практически невозможно отличить от изменений, вызванных обновлением модели.

На киберпреступных форумах уже встречаются обсуждения возможности внедрить в данные обучения некую "прививку", которая заставит нейросеть в определенных случаях вести себя нужным образом. И хотя пока такие обсуждения носят скорее теоретический характер, запрос на разработку уже сформулирован, значит его реализация вполне может появиться на свет.

Поможет ли отказ от ИИ?

Рост количества угроз, связанных с незаконным применением нейросетей, заставляет многих активных граждан высказываться за введение ограничений на доступ к этой технологии, за введение государственного надзора за применением ИИ и ужесточение наказаний за преступное использование глубокого обучения и смежных направлений. Однако принесут ли такие ограничения реальную пользу?

Преступники и сейчас действуют вне правового поля, зачастую используя нелегальный доступ к засекреченным технологиям для реализации кампаний. Поэтому ограничения скорее окажут негативное влияние на развитие общественно полезной технологии, чем помешают тем, кто планирует ее злонамеренное использование.

Гораздо эффективнее будет проанализировать настоящие и будущие угрозы, связанные с преступным применением нейросетей, и разработать меры адекватного противодействия, также построенные на базе глубокого обучения. При этом одной из важнейших задач станет обеспечение механизмов защиты данных модели с помощью системы проверки целостности на базе контрольной суммы или эталонных обучающих последовательностей с известными для модели результатами по набору ключевых точек.